三步搞定數據統計分析 從處理、分析到可視化

在當今數據驅動的時代,高效地進行數據統計分析已成為眾多領域的核心技能。無論是商業決策、學術研究還是日常運營,掌握一套清晰、高效的流程至關重要。本文將為您梳理一個精簡而強大的三步法:數據處理、統計分析、結果可視化,助您輕松駕馭數據,挖掘深層價值。

第一步:數據處理——夯實分析基礎

數據處理是整個統計分析流程的基石,其質量直接決定后續分析的可靠性與有效性。此階段的核心目標是獲取干凈、規整、可用于分析的數據集。

- 數據收集與導入:根據分析目標,從數據庫、API接口、電子表格或調查問卷等多種渠道收集原始數據,并將其導入到專業的分析工具(如Python的Pandas庫、R語言、Excel或SPSS)中。

- 數據清洗:這是最關鍵的一環。需要處理缺失值(如刪除、填充)、糾正錯誤值、識別并處理異常值,并確保數據格式的統一(例如,日期格式標準化、文本編碼一致)。

- 數據整理與轉換:對數據進行重構,使其符合分析需求。包括創建新的計算字段(如計算比率、增長率)、數據分組(分箱)、以及將數據從“寬格式”轉換為更適合分析的“長格式”等。

核心要義:寧可在數據準備階段多花時間,也絕不讓“垃圾數據”進入分析流程,正所謂“Garbage in, garbage out”。

第二步:統計分析——洞察數據內在規律

在堅實的數據基礎上,運用統計方法探索數據特征、檢驗假設并發現規律。此階段是從“數據”到“信息”的關鍵轉化。

- 描述性統計分析:首先對數據進行整體描述。計算核心指標,如均值、中位數、眾數(集中趨勢)、標準差、方差、極差(離散程度),以及通過分位數了解數據分布。制作頻數表、交叉表也是常見方法。

- 探索性數據分析:通過圖形化方法(如箱線圖、直方圖、散點圖矩陣)直觀探索變量分布、關系及異常點,形成初步假設。

- 推斷性統計分析:基于樣本數據推斷總體特征。常用方法包括:

- 參數檢驗:如t檢驗(比較兩組均值)、方差分析(比較多組均值)、相關分析與回歸分析(探究變量間關系)。

- 非參數檢驗:當數據不滿足參數檢驗假設時使用,如曼-惠特尼U檢驗、卡方檢驗等。

- 模型構建與驗證:對于更復雜的預測或解釋性問題,可能會建立統計模型(如線性回歸、邏輯回歸、時間序列模型),并利用訓練集/測試集等方法驗證模型效果。

核心要義:根據具體業務問題和數據特征,選擇合適的統計方法,避免誤用。理解每個檢驗的前提假設和結果的實際意義比單純運行軟件更重要。

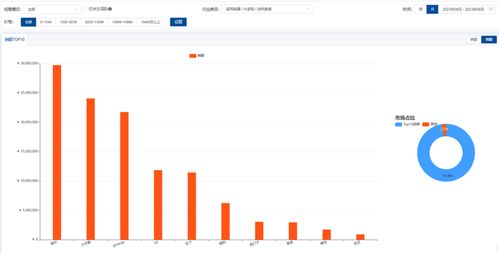

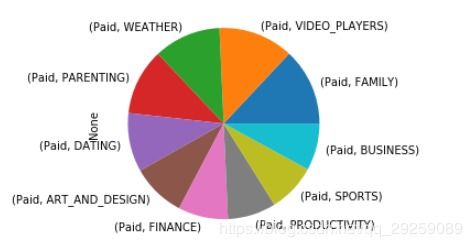

第三步:結果可視化——呈現洞察與驅動決策

分析得出的數字和結論需要通過直觀、易懂的方式呈現出來,才能有效溝通洞察,支持決策。可視化是連接分析與行動的橋梁。

- 選擇正確的圖表:

- 比較:條形圖、柱狀圖。

- 構成:餅圖(僅限少數類別)、堆疊柱狀圖、瀑布圖。

- 分布:直方圖、箱線圖、密度圖。

- 關系:散點圖、氣泡圖、熱力圖。

- 趨勢:折線圖、面積圖(時間序列)。

- 遵循可視化最佳實踐:

- 簡潔清晰:避免圖表垃圾,如不必要的3D效果、過度裝飾。

- 準確標注:確保坐標軸、圖例、標題清晰無誤。

- 突出重點:使用顏色、大小、標注等方式引導觀眾關注關鍵信息。

- 講述故事:將多個圖表按邏輯順序組織,形成一份連貫的數據分析報告或儀表板,闡述從發現問題到得出結論的全過程。

- 利用現代工具:借助Tableau、Power BI、Matplotlib、Seaborn、ggplot2等強大的可視化工具或庫,可以高效創建出兼具美觀與功能性的圖表和交互式儀表板。

核心要義:可視化的目標不是展示所有數據,而是高效傳達最重要的發現。一張優秀的圖表應能讓人在幾秒鐘內理解核心信息。

循環迭代,持續優化

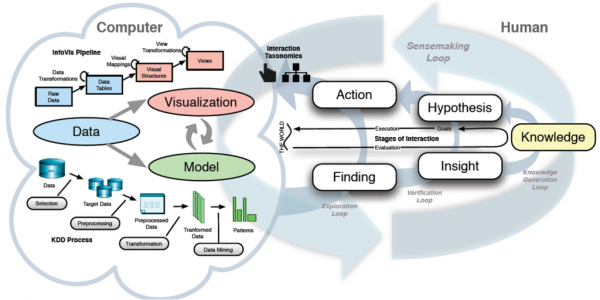

“處理-分析-可視化”這三步并非嚴格的一次性線性流程,而往往是一個循環迭代的過程。在可視化階段可能會發現新的問題或異常,需要返回數據處理階段進行核查;初步分析結論也可能促使我們收集新的數據或進行更深入的統計檢驗。

掌握這個三步框架,并輔以合適的工具(如Python生態中的Pandas、NumPy、SciPy、Matplotlib/Seaborn,或R語言中的tidyverse系列包),您就能系統性地應對大多數數據統計分析任務,將原始數據轉化為清晰的見解和有力的行動指南,真正實現數據價值的落地。

如若轉載,請注明出處:http://m.fanvff.cn/product/65.html

更新時間:2026-01-07 23:13:41